Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | |||||

| 3 | 4 | 5 | 6 | 7 | 8 | 9 |

| 10 | 11 | 12 | 13 | 14 | 15 | 16 |

| 17 | 18 | 19 | 20 | 21 | 22 | 23 |

| 24 | 25 | 26 | 27 | 28 | 29 | 30 |

Tags

- schema registry

- kafka streams

- kafka interactive query

- coursera

- Elk

- springboot

- play framework

- 한빛미디어

- gradle

- Spring

- aws

- enablekafkastreams

- scala 2.10

- Slick

- Elasticsearch

- confluent

- Logstash

- spring-cloud-stream

- statestore

- kafkastream

- spring-batch

- 플레이 프레임워크

- 카프카

- kafkastreams

- Kafka

- spring-kafka

- avo

- reactive

- RabbitMQ

- scala

Archives

- Today

- Total

목록kafka segment (1)

b

Kafka Segement

Kafka Segement

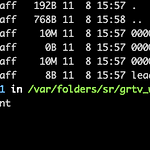

#topic 생성 kafka-topics --create --topic freblogg --partitions 3 --replication-factor 1 --zookeeper localhost:2181 - 파일명은 base offset에 영향을 받는다 (해당 세그먼트의 첫 번째 offset) 그러므로 새로 생성된 토픽-파티션의 첫번째 세그먼트는 항상 0000000000000.log 파일명이다. 간단하게 2개의 메시지를 넣고 다시 한번 0번 파티션을 확인해보면 0000000000000.log 의 파일 크기가 변경되고 그 안을 보면 해당 데이터가 들어간것을 확인 할 수 있다 이를 좀 더 자세히 보려면 아래의 명령어처럼 세그먼트 내부를 확인 할 수 있다. ( DumpLogSegments ) ~/conflue..

카테고리 없음

2019. 11. 8. 16:26